Une seule ligne de code distingue un bon robot d'un mauvais

sur

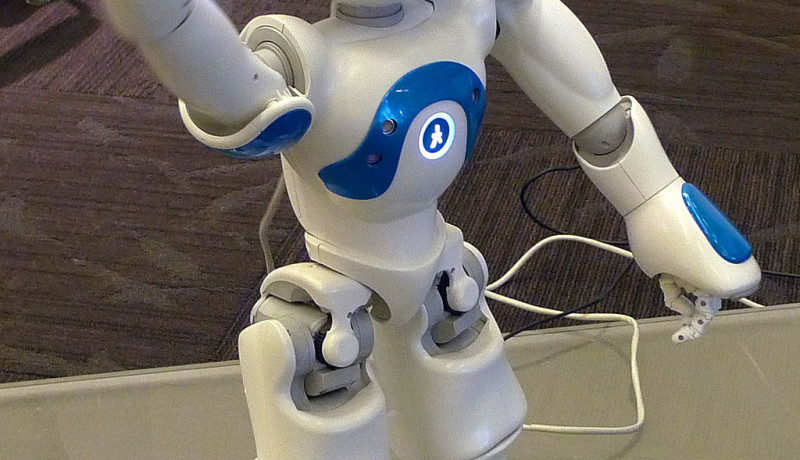

Photo : Anonimski

Depuis longtemps, Winfield se consacre au développement de robots éthiques. Dans une interview accordée à Elektor Ethics en 2016, il a évoqué une expérience dans laquelle il avait programmé un robot pour sauver des gens. Le robot pouvait évaluer les conséquences des actions possibles avant de faire quelque chose. Une règle éthique immuable codée dans le logiciel s'assurait que le robot, au risque de sa propre intégrité, effectuerait toujours l'action qui sauverait une ou plusieurs vies humaines. À cette époque, Winfield considérait cela comme une garantie de sécurité pour les gens, alors que les robots sont de plus en plus impliqués dans notre vie quotidienne.

Mais Winfield a effectué de nouvelles expériences qui jettent un doute sur ses conclusions précédentes.

Du bon au mauvais, il n'y a qu'une ligne

Pour qu'un robot éthique puisse choisir la meilleure action pour autrui, il doit connaître les objectifs et les préférences de cette personne. Mais cette connaissance approfondie transforme le robot en un facteur de risque car il peut aussi l'utiliser pour trahir. Dans une publication conjointe, Alan Winfield et Dieter Vanderelst, de l'université de Cincinnati (USA), illustrent clairement cette situation par une expérience simple.Un joueur participe à un tour de passe-passe avec un professionnel entraîné. Si le joueur devine lequel de trois gobelets cache une bille, il double sa mise initiale. Dans le cas contraire, il la perd. Un robot appelé Walter aide le joueur en évaluant son comportement. S'il se dirige vers le bon gobelet, le robot ne réagit pas. Mais s'il se dirige vers le mauvais, Walter indique la bonne direction. Pour fournir cette aide, Walter a besoin de savoir beaucoup de choses : les règles du jeu, la bonne réponse, et ce que la personne veut faire, à savoir gagner. Mais cette connaissance peut être mise à profit différemment. Selon les mots de Winfield et Vanderelst :

« Le mécanisme cognitif dont Walter a besoin pour se comporter de manière éthique est très vulnérable. En fait, il suffit d'un changement insignifiant du programme pour transformer Walter l'altruiste en machine égoïste. En mettant à profit sa connaissance du jeu, Walter peut facilement optimiser ses propres gains en découvrant la bille avant que le joueur n'ait fait son choix. Notre expérience montre que la modification d'une seule ligne de code, [...] change le comportement du robot de l'altruisme au chacun pour soi »

Notre responsabilité est en jeu

Bien entendu, ce n'est pas le robot qui se retourne contre la personne puisqu'il n'a pas de libre arbitre. Comme Winfield et Vanderelst l'indiquent, ce ne peut être que le fait d'un tiers. Par exemple, un fabricant peu scrupuleux ou bien un cyber-criminel pourraient manipuler le logiciel au détriment de l'utilisateur. Les auteurs concluent que le risque est si élevé qu'il est probablement déraisonnable de développer des robots dotés de mécanismes de prise de décisions éthiques.Avec cette publication, il semble que Winfield prenne le contrepied de ses expérimentations sur les robots éthiques. Toutefois, ses recherches sur les robots éthiques sont beaucoup plus étendues. Il a toujours clamé que ce sont les êtres humains, et non les robots, qui sont responsables de leurs agissements. Maintenant qu'une solution technologique apparaît comme une impasse, il est plus important que jamais d'assumer notre responsabilité. « Il est temps de jeter les bases d'une autorité et d'un cadre réglementaire pour le déploiement éthique de robots dans la société », concluent les auteurs.

Ces expériences montrent également qu'un ensemble de règles éthiques ne remplace pas la conscience morale.

Discussion (0 commentaire(s))